Las ecuaciones diferenciales, ya sean ordinarias o parciales, pueden clasificarse de forma rentable como lineales o no lineales. Las ecuaciones diferenciales lineales son aquellas para las que la suma de dos soluciones es de nuevo una solución. La ecuación que da la forma de una cuerda vibrante es lineal, lo que proporciona la razón matemática por la cual una cuerda puede emitir simultáneamente más de una frecuencia. La linealidad de una ecuación hace que sea fácil encontrar todas sus soluciones, por lo que en general los problemas lineales se han abordado con éxito, mientras que las ecuaciones no lineales siguen siendo difíciles. De hecho, en muchos problemas lineales se puede encontrar una familia finita de soluciones con la propiedad de que cualquier solución es una suma de ellas (convenientemente multiplicada por constantes arbitrarias). La obtención de tal familia, llamada base, y su puesta en su forma más simple y útil, fue una fuente importante de muchas técnicas en el campo del álgebra lineal.

Consideremos, por ejemplo, el sistema de ecuaciones diferenciales lineales

Es evidentemente mucho más difícil de estudiar que el sistema

cuyas soluciones son (múltiplos constantes de)

Pero si se puede encontrar una combinación lineal adecuada de e

para que el primer sistema se reduzca al segundo, entonces es suficiente resolver el segundo sistema. La existencia de tal reducción está determinada por una matriz de cuatro números. En 1858 el matemático inglés Arthur Cayley comenzó el estudio de matrices por derecho propio cuando notó que satisfacen ecuaciones polinómicas. La matriz

por ejemplo, satisface la ecuación . Además, si esta ecuación tiene dos raíces distintas -digamos

y

– entonces existirá la reducción buscada, ylos coeficientes del sistema más simple serán las raíces

y

. Si la ecuación tiene una raíz repetida, entonces la reducción usualmente no puede ser llevada a cabo. En cualquier caso, la parte difícil de resolver la ecuación diferencial original se ha reducido a álgebra elemental.

El estudio del álgebra lineal iniciado por Cayley y continuado por Leopold Kronecker incluye una poderosa teoría de los espacios vectoriales. Estos son conjuntos cuyos elementos pueden ser sumados y multiplicados por números arbitrarios, como la familia de soluciones de una ecuación diferencial lineal. Un ejemplo más familiar es el del espacio tridimensional. Si uno escoge un origen, entonces cada punto en el espacio puede ser etiquetado por el segmento de línea (llamado vector) uniéndolo al origen. Las matrices aparecen como formas de representar transformaciones lineales de un espacio vectorial, es decir, transformaciones que preservan sumas y multiplicaciones por números: la transformación es lineal si, para cualquier vector

,

y, para cualquier escalar ,

Cuando el espacio vectorial es de dimensión finita, el álgebra lineal y la geometría forman una potente combinación. También se estudian espacios vectoriales de dimensiones infinitas.

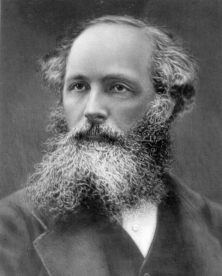

La teoría de los espacios vectoriales es útil de otras maneras. Los vectores en el espacio tridimensional representan conceptos tan importantes desde el punto de vista físico como las velocidades y las fuerzas. Esta asignación de un vector a un punto se denomina campo vectorial. Los ejemplos incluyen campos eléctricos y magnéticos. Científicos como James Clerk Maxwell y Josiah Willard Gibbs tomaron el análisis vectorial y fueron capaces de extender los métodos vectoriales al cálculo. Introdujeron de esta manera las medidas de cómo un campo vectorial varía infinitesimalmente, que bajo los nombres div, grad y curl, se han convertido en las herramientas estándar en el estudio del electromagnetismo y la teoría del potencial.

James Clerk Maxwell

Josiah Willard Gibbs

Para el matemático moderno, div, grad y curl forman parte de una teoría a la que la ley de Stokes (un caso especial del cual es el teorema de Green) es central. El teorema de Gauss-Green-Stokes, llamado así por Gauss y dos matemáticos aplicados ingleses del siglo XIX (George Green y George Stokes), generaliza el teorema fundamental del cálculo a funciones de varias variables. El teorema fundamental del cálculo afirma que

que se puede leer diciendo que la integral de la derivada de alguna función en un intervalo es igual a la diferencia en los valores de la función en los extremos del intervalo. Generalizado a una parte de una superficie o un espacio, esto afirma que la integral de la derivada de alguna función sobre una región es igual a la integral de la función sobre la frontera de la región. En símbolos esto dice que , donde la primera integral se toma sobre la región en cuestión y la segunda integral sobre su frontera, mientras que

es la derivada de

.

![]()

George Stokes